I ricercatori di Oxford avvertono che i chatbot basati sull’intelligenza artificiale rappresentano un rischio per la scienza.

I grandi modelli linguistici (LLM) come ChatGPT e Bard potrebbero rappresentare una minaccia per la scienza a causa di false risposte, sostengono i ricercatori di Oxford AI in un nuovo articolo, che insiste sul fatto che il loro uso nella ricerca scientifica dovrebbe essere limitato.

Gli LLM sono modelli di deep learning che alimentano i chatbot di intelligenza artificiale (AI) e sono in grado di generare testo simile a quello umano.

I ricercatori dell’Oxford Internet Institute affermano che le persone hanno troppa fiducia in questi modelli e li vedono come una risorsa simile a quella umana.

“Ciò è, in parte, dovuto alla progettazione degli LLM come agenti utili e dal suono umano che conversano con gli utenti e rispondono apparentemente a qualsiasi domanda con testi ben scritti e dal suono sicuro”, Brent Mittelstadt, direttore della ricerca presso l’Oxford Internet Institute , si legge in un comunicato.

“Il risultato di ciò è che gli utenti possono essere facilmente convinti che le risposte siano accurate anche quando non hanno alcun fondamento nei fatti o presentano una versione distorta o parziale della verità”, ha affermato.

Tuttavia i LLM non garantiscono risposte accurate e potrebbero fornire false informazioni provenienti dai dati di addestramento o potrebbero generare false informazioni (note come allucinazioni) mentre il tono dell’output rimane convincente per l’utente.

Perché i ricercatori non dovrebbero fidarsi dei LLM?

Anche se molte risposte dei chatbot saranno accurate, non vi è alcuna garanzia e i set di dati utilizzati per addestrare questi modelli di intelligenza artificiale possono causare risultati falsi.

Se ad esempio i set di dati, che spesso provengono da contenuti Internet, contengono “false dichiarazioni, opinioni, battute, scritti creativi”, come affermano i ricercatori, ciò può portare a risultati errati.

Un altro problema è che gli LLM sono notoriamente riservati riguardo ai loro set di dati.

In un’indagine, il Washington Post ha rivelato, ad esempio, che il set di dati di Bard – che è secondo in popolarità dopo ChatGPT – includeva vari forum Internet, blog personali e siti Web dedicati all’intrattenimento come Screenrant.

Per Mittelstadt, la preoccupazione principale non sono le allucinazioni più evidenti, ma piuttosto i risultati che sono “leggermente errati o leggermente distorti, o per cui è necessaria una competenza specifica per dire che è sbagliato”, ha detto a Euronews Next.

Ciò può essere il caso, ad esempio, dei riferimenti ad articoli scientifici.

“Uno dei grossi problemi è che inventeranno completamente i riferimenti e se non torni indietro a cercarli, non ti renderai conto che in realtà si tratta di un articolo completamente inventato. Oppure il riferimento potrebbe essere giusto, ma potrebbe dare informazioni sbagliate su ciò che dice il giornale”, ha detto.

“Considero ChatGPT e i modelli linguistici come un assistente di ricerca molto inaffidabile. Quindi, qualunque cosa mi dia, lo verificherò sempre e mi assicurerò sempre che sia vero”, ha aggiunto.

Quali sono le soluzioni?

ChatGPT avvisa gli utenti che il chatbot potrebbe fornire informazioni imprecise.

Tuttavia i ricercatori raccomandano di utilizzare il modello linguistico ampio non come “base di conoscenza” ma piuttosto come “traduttore a colpo zero”.

“È quando fornisci al modello una serie di input che contengono informazioni o dati affidabili, oltre a qualche richiesta di fare qualcosa con quei dati. E si chiama traduzione zero-shot perché il modello non è stato addestrato specificamente per gestire quel tipo di suggerimento”, ha affermato Mittelstadt.

Ciò significherebbe riscrivere un testo in un linguaggio più accessibile, “curare i dati” o “tradurre i dati da un formato all’altro”.

“Il modo in cui vengono utilizzati gli LLM è importante. Nella comunità scientifica, è fondamentale avere fiducia nelle informazioni fattuali, quindi è importante utilizzare i LLM in modo responsabile. Se gli LLM venissero utilizzati per generare e diffondere articoli scientifici, potrebbero derivarne gravi danni”, ha affermato Sandra Wachter, coautrice dello studio.

I ricercatori di Oxford non sono gli unici ad affermare che sono necessari dei guardrail quando si tratta di utilizzare ChatGPT nella scienza.

Nature, la principale pubblicazione scientifica a livello mondiale, ha deciso all’inizio dell’anno che “nessuno strumento LLM sarà accettato come autore accreditato su un documento di ricerca“come questione di responsabilità.

Inoltre, la pubblicazione richiedeva agli autori di divulgare l’uso di un ampio modello linguistico in una sezione del loro articolo.

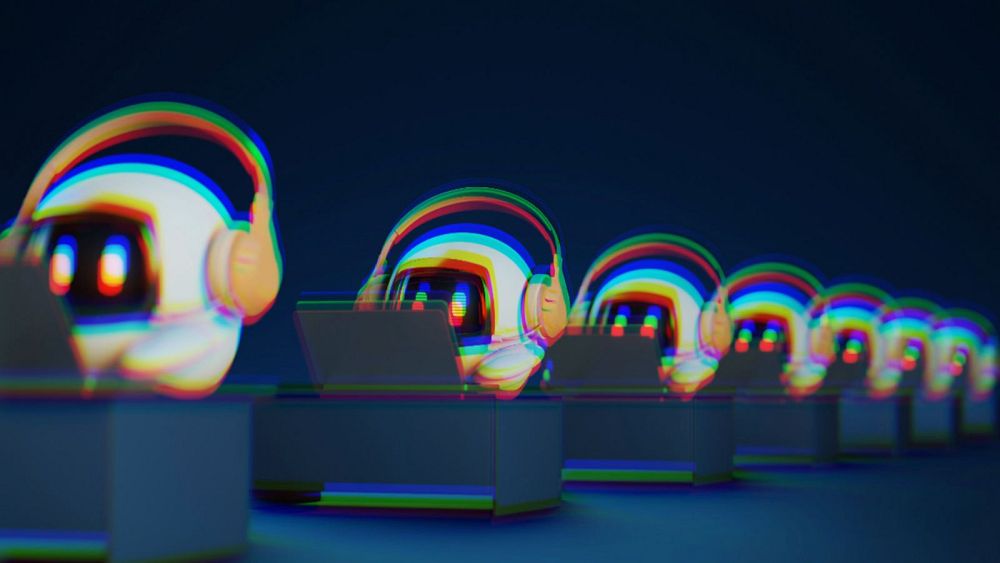

Image:Getty Images