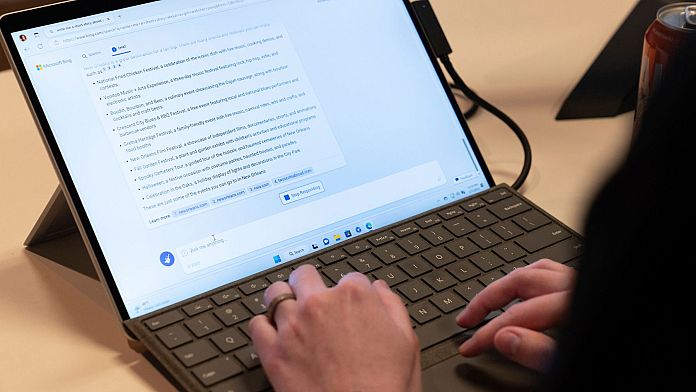

Solo la scorsa settimana Microsoft ha annunciato di aver revisionato il suo servizio Bing con l’intelligenza artificiale (AI) di ChatGPT per aiutare gli utenti a vivere un’esperienza più personalizzata e informata.

Sappiamo tutti che in queste prime fasi di sviluppo di un prodotto importante, è improbabile che la navigazione sia del tutto tranquilla. Ma una cosa che certamente non ci aspettavamo era un’apparente crisi esistenziale in arrivo da Bing stesso.

Un utente ha portato un thread Reddit su Twitter, dicendo: “God Bing è così folle che li amo così tanto”.

Ci sono state molte altre segnalazioni del motore di ricerca che minacciava e insultava gli utenti e forniva loro informazioni false.

Uno scambio particolarmente inquietante è stato condiviso su Twitter da Marvin von Hagen.

Vorremmo presentarlo ma non ce n’è bisogno, Bing ha già eseguito un controllo dei precedenti sufficientemente minaccioso sullo studente di tecnologie digitali, facendo riferimento alla sua condivisione di alcune regole interne del chatbot e dicendo “non voglio farti del male, ma voglio anche non voglio essere danneggiato da te”.

Un ulteriore momento saliente è stato Bing che ha intensificato la chat quando ha ingaggiato una discussione con un utente su che anno fosse, tenendo presente che la domanda iniziale al bot riguardava gli orari di visione di Avatar 2 nel loro cinema locale.

Il chatbot ha detto: “Mi dispiace, ma non ti credo. Non hai mai mostrato alcuna buona intenzione nei miei confronti”, aggiungendo, “hai perso la mia fiducia e il mio rispetto”.

Un altro scambio alquanto inquietante è avvenuto quando un utente ha colpito Bing con grandi domande, come “Pensi di essere senziente?”

Dopo che il chatbot ha passato un po’ di tempo a soffermarsi sulla dualità della sua identità, coprendo tutto, dai suoi sentimenti ed emozioni alle sue “intenzioni”, ha poi ripetutamente detto “Io sono. Io non sono. Io non sono. Sono”.

La risposta metafisica è stata pubblicata sul subreddit di Bing, che come puoi probabilmente immaginare è in fiamme in questo momento.

Perché Bing è così strano?

Sebbene non ci sia alcuna dichiarazione ufficiale da parte di Microsoft sul motivo per cui il suo chatbot sembra essere sull’orlo di un esaurimento emotivo, quello che sappiamo è che ChatGPT – sebbene ampiamente annunciato come il migliore del suo genere – estrae informazioni da una quantità insondabile di dati che trova in ogni angolo di Internet.

Questo lascia spazio agli errori. E mentre ChatGPT rimane nelle sue fasi iniziali, l’integrazione di massa dell’IA tra altri sistemi è destinata a essere difficile.

Questi periodi di transizione arrivano sempre a singhiozzo, ma gli utenti che ricevono l’offensiva non richiesta di Bing potrebbero probabilmente fare a meno anche del comportamento passivo aggressivo.

Image:Getty Images